L’A/B testing est une formidable méthode pour améliorer vos campagnes marketing. Il s’agit d’un process qui permet de comparer les performances de deux contenus (image, texte, etc.) pour choisir le plus efficace. Par exemple, il permet d’évaluer l’impact du changement d’une variable (couleur d’un bouton, formulation d’un call to action) sur une autre variable, généralement de conversion (taux de clic, remplissage d’un formulaire, etc.).

Comment mettre en place un A/B test, quelle méthode suivre, comment interpréter les résultats pour améliorer vos campagnes ? On vous raconte tout. 👇🏻

Qu’est-ce que l’A/B testing ?

Définition

L’A/B testing est une méthode permettant de comparer les performances de deux versions A et B d’un contenu, en diffusant chaque version à un échantillon d’individus distincts puis en comparant les performances pour, enfin, choisir la version la plus performante. Ce peut être, par exemple, le contenu d’une page web, d’une application mobile, d’un e-mail ou d’une bannière publicitaire dans le parcours d’un utilisateur (qu’il soit visiteur, prospect ou déjà client).

Il est parfois appelé split testing (test de division en français).

L’exemple de Google

Vous avez probablement remarqué que Google présente les résultats de recherche de son moteur sous forme de pages contenant dix résultats naturels. Ce nombre a été fixé en 1998 suite à un A/B testing. C’est la quantité idéale, selon les calculs de l’époque, de résultats pour que l’internaute ait l’impression d’avoir un choix suffisant d’une part, mais qu’à l’inverse il ne soit pas noyé devant trop de choix.

Google utilise également l’A/B testing en continue dans le cadre de ses campagnes Google Ads (ex Google Adwords) en comparant les publicités qui fonctionnent le mieux auprès de son audience.

Pourquoi utiliser l’A/B testing ?

Cette méthode est utile à toutes les étapes du funnel marketing :

- Dans les campagnes publicitaires d’acquisition de trafic,

- Pour convertir un internaute en prospect,

- Pour convertir un prospect en client.

Il est utilisé depuis longtemps dans les campagnes de mailing postal, par exemple en envoyant un courrier avec un texte différent à deux échantillons de destinataires. Le tracking pouvait être réalisé dans ce cas grâce à un code de promotion différent propre à chaque échantillon. Le courrier dont le contenu générait le plus de ventes était envoyé à l’ensemble des destinataires à la campagne suivante.

Mais son usage a été décuplé avec le développement du marketing digital, qui génère plus d’occasions de mesurer les conversions des utilisateurs, une plus grande simplicité à les mesurer et à diffuser la version la plus efficace. Aujourd’hui, trois quarts des sites ayant plus d’un million de visiteurs annuels pratiquent l’A/B testing.

Vous allez découvrir comment l’A/B testing fonctionne, ce que vous pouvez tester grâce à ce procédé, les étapes pour mettre en place un test et nos conseils pour mettre en place une stratégie efficace.

Comment fonctionne l’A/B testing ?

Le fonctionnement

Le principe

L’A/B testing consiste à diffuser deux versions d’un même contenu, qu’il soit graphique (page web, formulaire, call to action) ou non, auprès de deux échantillons de taille similaire d’une même audience, afin de comparer leurs performances respectives.

Deux versions

Un A/B test compare, comme son nom l’indique, deux versions A et B au minimum. Mais sur des sites à fort trafic, il est courant de comparer plus de deux versions.

Une hypothèse de départ

Ce test s’appuie sur une hypothèse en lien avec le design, la structure ou le contenu du site. Bref, sur l’expérience utilisateur (UX) ou l’UI. Par exemple : un bouton de confirmation d’achat en vert convertit-il mieux qu’un bouton rouge ?. En comparant les deux versions du site, nous sommes en mesure de confirmer ou d’infirmer l’hypothèse de départ.

Exemple d’A/B testing

Contexte

Une page d’un site contient un formulaire pour recevoir un livre blanc « Comment réussir sa campagne publicitaire sur Facebook ». Son objectif est de convertir un internaute anonyme en prospect qualifié pour des formations à la plateforme publicitaire de Facebook. La page se compose d’une description du livre blanc, d’un formulaire et d’un call-to-action sur lequel est écrit « Téléchargement ».

Hypothèse

En modifiant la formulation du call-to-action de « Téléchargement » (descriptif et peu incitatif) à « Je découvre les 10 astuces pour réussir ma campagne Facebook », le taux de conversion d’internaute à prospect pourrait être amélioré.

Fonctionnement

Grâce à un outil d’A/B testing, la nouvelle page avec le bouton est présentée à un échantillon significatif d’internautes.

Résultat

Après quatre semaines de test, on s’aperçoit que le taux de conversion (du statut d’internaute à celui de prospect qualifié) est passé de 3% à 4%. Le résultat est concluant, la nouvelle version sera conservée.

Combien d’éléments peut-on tester ?

On peut tester une variable comme la couleur d’un bouton par exemple. On l’appelle alors test univarié.

La version B obtient un taux de conversion de 50 % alors que la version de contrôle (A) n’a que 30 %.

On peut tester plus de deux variables : agencement de la page et couleur des boutons par exemple. Il s’agit alors d’un test multivarié.

Il faut, pour chaque variation, avoir suffisamment d’individus qui testent (voir ci-dessous notre explication sur la fiabilité). Lorsque l’on teste une page entière sur laquelle on a modifié plusieurs éléments, il faut considérer la page comme une variable en tant que telle. Il serait trop difficile de savoir quel élément a eu ou non un impact.

Que peut-on tester avec l’A/B testing ?

Il permet de comparer la performance, c’est-à-dire la probabilité d’atteindre un objectif défini, de :

- Campagne emailing,

- Pages web,

- Formulaires,

- Landing page,

- Visuels publicitaires.

Et cela en faisant varier des éléments comme :

- Titres,

- Pages produits,

- Textes,

- Affichages des prix,

- Couleurs.

En mesurant des résultats :

- visites (trafic),

- rebond,

- clic,

- conversion.

Les 7 étapes pour mener un A/B test

L’A/B testing, sous ses abords ludiques, n’est autre qu’une étude quantitative, qui exige de suivre rigoureusement sept étapes bien définies.

1re étape | Définir l’objectif du test.

L’objectif principal d’un site varie selon le secteur d’activité, son audience, etc. : simple navigation au sein des pages, génération de leads, ventes, etc.

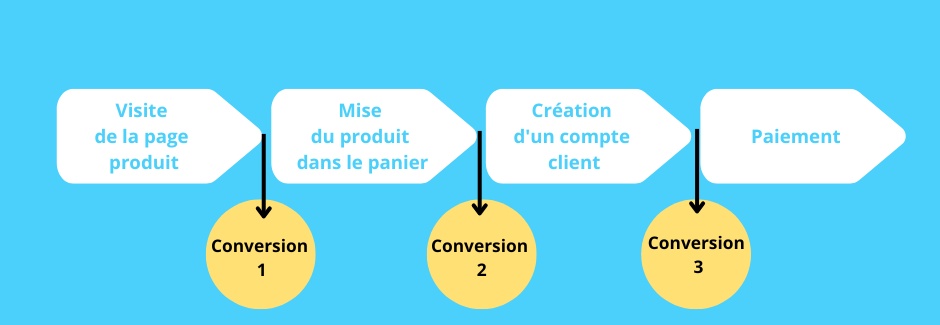

Avant que l’objectif principal ne soit réalisé, le visiteur va atteindre différents sous-objectifs, au gré de son parcours dans le tunnel de conversion. Par exemple, pour un site e-commerce, l’objectif principal est de vendre des produits. Pour atteindre cet objectif, le visiteur passera probablement par les étapes suivantes :

Dans cet exemple, on pourra essayer d’améliorer la conversion à chaque étape (1, 2, 3), mais l’objectif du test serait d’améliorer le taux de conversion final : le nombre de visiteurs achetant le produit.

2e étape | Définir l’élément à tester.

L’élément à tester est une variable (couleur d’un bouton par exemple) qui a une influence sur le taux de conversion final. Cette variable pouvant intervenir dans l’une ou l’autre des étapes du tunnel de conversion.

On peut identifier cette variable de deux manières différentes :

- De manière objective et empirique, en observant la chute d’une statistique (par exemple : vous recevez 100 000 visiteurs sur votre site, mais seulement 1 % se rend sur des pages produits),

- De manière intuitive parce que vous pensez que le changement de tel ou tel élément (mieux intégrer les liens menant vers vos pages produits par exemple) pourra améliorer votre taux de conversion.

On peut tester une variable (la couleur d’un bouton par exemple) ou plusieurs variables (sa couleur et sa position sur la page par exemple), voire une page entière.

3e étape | Noter les performances actuelles.

Il faut noter les performances actuelles correspondant à la variable : par exemple le taux de visiteurs arrivant sur une page produit. Mais il faut également noter toutes les métriques, notamment les taux de conversion, du début à la fin du parcours client. Cela permettra de vérifier qu’un changement à un point précis n’influencera pas un autre point dans la suite du parcours client. Vous devez donc mettre en place un outil de tracking statistiques, comme Google Analytics.

4e étape | Définir la version de contrôle et la version de variation, les créer et les diffuser.

- La version de référence, ou de contrôle, est la version A.

- La version test, ou version de traitement, ou version de variation est la version B.

Il faut créer les contenus pour chacune des variantes.

5e étape | Collecter suffisamment de données.

L’A/B testing étant une étude quantitative, qui mesure des comportements, elle aboutit à des résultats chiffrés, comme des statistiques. Pour obtenir des résultats fiables, il faut donc diffuser chaque variante du test à un nombre important d’internautes pour atteindre une signification statistique (voir définition ci-dessous). On peut l’estimer à minimum 2 000 visiteurs pour une page dont on veut tester deux variantes afin de faire tester 1 000 visiteurs pour chacune des variantes.

Signification statistique

Stade qui est atteint lorsque la statistique est véritable, que le résultat observé sur l’échantillon sera effectivement observé dans la population totale, à une marge d’erreur près. Un taux d’erreur est accepté, souvent de 5 %, parfois moins dans certains secteurs.

6e étape | En tirer des conclusions et prendre en compte l’ensemble du tunnel d’achat.

Vous avez peut-être constaté que changer la couleur du call-to-action de bleu à rouge générait plus de clics sur ce bouton. Mais les personnes ayant cliqué sur le rouge ont-elles été autant converties en clients payants, en fin de tunnel, que celles ayant cliqué sur le bleu ?

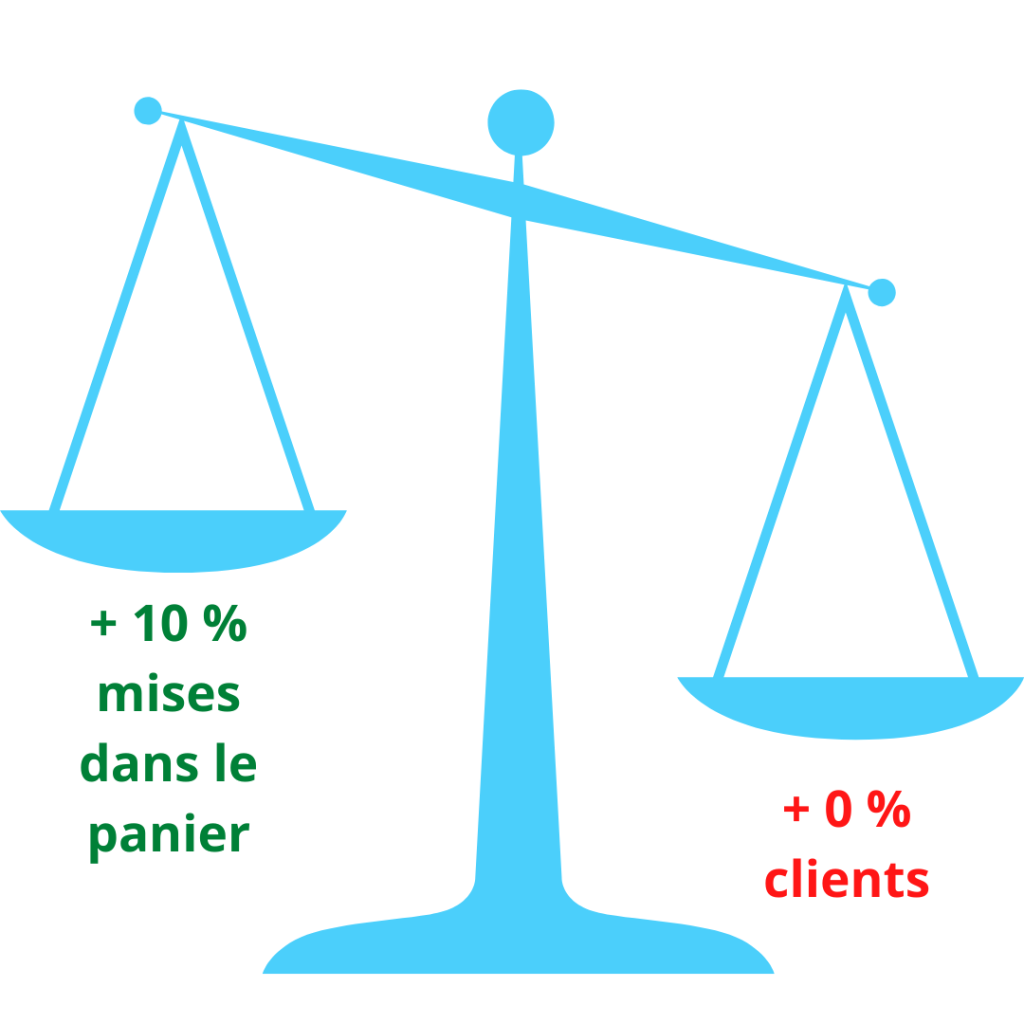

C’est la différence, sur un site e-commerce par exemple, entre les conversions intermédiaires et la conversion finale (la vente). On peut par exemple améliorer les micro-conversions : améliorer le pourcentage de mise en panier des articles. Mais il faut garder un œil sur la (macro) conversion finale : le produit est-il finalement plus acheté avec cette nouvelle mise en page ?

Comment éviter d’améliorer les taux de conversion, mais diminuer sa rentabilité ?

On pourrait par exemple constater qu’un taux plus important de visiteurs mettent des produits dans leur panier (puisque nous avons amélioré les incitations à le faire « mettez le produit dans le panier, il vous est réservé 30 minutes » par exemple),mais qu’à la fin, il y a toujours le même pourcentage de conversion visiteurs/payeurs.

Il faut mesurer l’impact des micro-conversions sur la macro-conversion.

7e étape | Mettre en application les conclusions.

Pour toutes ces étapes, vous pouvez vous faire accompagner par une entreprise comme Kameleoon ou Optimizely, AB Tasty.

Comment s’assurer de la fiabilité d’un A/B test ?

L’A/B testing est une méthode très efficace pour optimiser la conversion de vos stratégies marketing et in fine augmenter les revenus et la rentabilité de votre activité. Mais pour qu’il soit efficace et ne pas s’appuyer sur des données erronées lors de la prise de décision, quatre facteurs doivent être vérifiés :

- La taille de l’échantillon,

- La durée du test,

- Le taux de confiance,

- La puissance.

Comment calculer la taille de l’échantillon nécessaire ?

C’est un point essentiel pour que les résultats de l’A/B test soient fiables. La fiabilité visée est de 80 %, c’est-à-dire que l’on vise 80 % de probabilité que le résultat espéré se vérifie.

1re étape | Préparer les statistiques nécessaires.

Vous avez besoin des statistiques de la page :

- Le taux de conversion de la page à tester (par exemple pourcentage inscriptions/visiteurs ou pourcentage commandes/visiteurs),

- Le nombre de visiteurs uniques qui se rendent sur la page à tester.

2e étape | Définir le gain de conversions attendu grâce à la nouvelle version.

Vous devez ensuite définir le pourcentage d’amélioration attendu. Il faut bien distinguer ce que vous aimeriez… et ce que vous pensez raisonnablement obtenir. C’est cette dernière information que l’on vous demande.

C’est une partie très complexe, car on vous demande d’imaginer le résultat du test avant même de l’avoir mené ! Cela paraît peu logique, mais c’est pourtant simple : plus le gain recherché (la différence de performance entre la version de contrôle et la variation) est grand, plus il sera visible et donc plus il sera simple et rapide de le détecter, même avec peu de visiteurs dans l’échantillon.

À l’inverse, plus le résultat attendu est faible, plus grand devra être l’échantillon. C’est pour cela qu’il faut définir en amont le résultat attendu.

En grossissant le trait, si vous voulez doubler le nombre de conversions, donc gagner 100 % de conversion, vous aurez besoin d’un petit échantillon de visiteurs.

Il est difficile d’estimer le gain lorsque l’on débute. Pour donner un ordre de grandeur, un changement significatif (pas simplement la couleur d’un bouton) peut améliorer le taux de conversion de 5 points (pourcentage), ce qui serait un bon taux. Les professionnels du secteur s’accordent à dire que viser 10% d’amélioration du taux de conversion sur l’objectif global (visiteurs/vente, par exemple) est très ambitieux (il serait le résultat d’une refonte profonde et très innovante du site).

On voit donc que pour obtenir un uplift de 5 %, avec une fiabilité raisonnable (80 %) il faut que 100 000 visiteurs se rendent sur chacune des pages à tester.

Combien de temps doit durer le test ?

Reprenons l’exemple précédent. Si votre site reçoit 10 000 visites par jour et que vous testez deux offres, vous aurez besoin d’attendre 200 000/10 000 = 20 jours pour avoir un résultat significatif, avec une fiabilité à 80 %. Il est recommandé d’arrondir la durée en respectant les cycles business (la semaine) afin d’éviter les effets « jour de la semaine ». En effet, le comportement d’achat varie d’un jour à l’autre de la semaine).

Globalement, un A/B test doit respecter un seuil minimal et un plafond maximal, dans les deux cas pour éviter des biais provoqués par les changements de comportement au sein d’un intervalle de temps.

Seuil minimal : 2 semaines

Les experts s’accordent à demander deux cycles de vente, c’est-à-dire deux semaines, et cela, quel que soit le trafic, afin d’éviter les variations de comportements les différents jours de la semaine.

Seuil maximal : 1 mois

L’essai ne doit idéalement pas dépasser 30 ou, au pire, 60 jours. Au-delà, des paramètres peuvent changer. C’est par exemple le cas de la saisonnalité de votre activité, qui affecte la majorité des marchés. Le comportement d’un consommateur cherchant un maillot de bain variera entre janvier et avril. C’est également le cas pour les paramètres techniques : environ 10 % des internautes effacent leurs cookies tous les mois… ce qui influence les résultats.